LDA Linear Discriminant Analysis [빅공남! 통계 같이해요]

LDA Linear Discriminant Analysis 선형판별분석 차원축소 기법 공부를 주제로 오늘 포스팅을 준비했습니다. 지난 포스팅에서 공부했던 PCA(Principle Compnent Analysis) 주성분분석과 Linear Projection한다는 점에서는 비슷한 방법이라고 할 수 있습니다. 하지만 두 기법은 축(Axis)를 다른 방법으로 잡아간다는 점에서 다른 차원 축소 기법입니다. 그래서 오늘 포스팅에서는 LDA에 대해서 알아보고 어떤 차이점이 있는지 알아보도록 합니다. 유튜브 영상은 포스팅 맨 하단에 첨부하도록 하겠습니다.

1. LDA(Linear Discriminant Analysis)란?

LDA 선형판별분석은 단어 그래도 LInear하게 Discriminant 판별하는 분석법입니다. 즉 Linear한다는 의미는 PCA 기법처럼 직선 방향으로 축(Axis)를 잡아가는 것을 의미합니다. 축(Axis)를 잡고, 이 Axis 방향의 선형 결합으로 만든 공간으로 정사영(Projection)시키게 됩니다. 이러한 축을 순서대로 LD1, LD2, LD3 , ... 로 잡아가게 되는 것입니다. 그러면 어떻게 축(Axis)를 찾을 것인가가 중요한 아이디어가 됩니다.

LDA는 Class를 분류하는 차원축소기법으로 Class간 분산과 각 Class내 분산의 크기를 측정하게 됩니다.

결국 아래와 같이, LDA는 Class 분산의 2가지 관점에서 축을 잡습니다.

1) Class간 분산이 최대

2) Class내 분산이 최소

직선의 방향을 바꿔가면서 Projection 시킨 데이터의 클래스간, 클래스 내 분산을 측정하고, 구분을 잘되는 축을 잡아갑니다. 이때 LDA 기법은 고유값, 고유벡터로 바꿀 수 있습니다. PCA계산에서 사용한 공분산행렬과 달리, Class간, 클래스내 분산 행렬로 부터 고유값, 고유벡터 문제를 풀게 됩니다. 이는 파이썬 코딩을 통해서 고유값, 고유벡터를 계산해 낼 수 있게 됩니다.

LDA로 Class가 최대한 잘 구분이 되는 축(Axis)를 잡기 위해서는, Class가 주어져야 합니다. 즉, Target이 같이 input으로 주어지게 됩니다. LDA는 이러한 점에서 지도학습(Supervised Learning)에 해당하게 됩니다. 이는 파이썬 코딩에서도 input으로 들어간 것을 확인할 수 있습니다.

<싸이킷런 활용 PCA 코딩 example>

<싸이킷런 활용 LDA 코딩 example>

2. LDA vs PCA

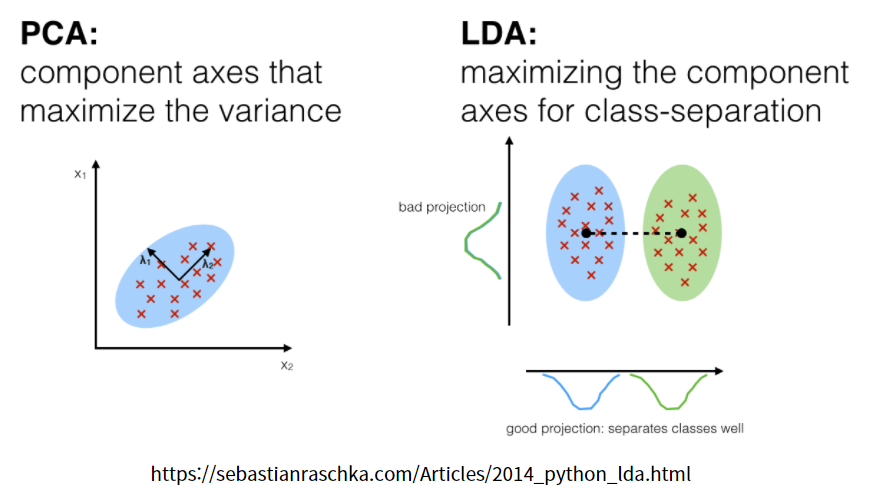

PCA기법과 LDA 기법은 공통점과 차이점이 있습니다. 두 기법 모두 Linear Projection을 한다는 점에서 공통점으로 볼 수 있고, 비지도 학습 vs 지도학습으로 차이도 확인 할 수 있습니다. 특히, 축을 잡는 방법에서 큰 차이점을 볼 수 있습니다.

1) PCA

1) Unsupervised

2) 분산이 최대가 되는 방향으로 Projection

(2) LDA

1) Supervised

2) 집단의 분류(Classfication)가 잘되는 방향으로 Projection

아래 그림처럼 PCA는 집단의 구분없이, 데이터 셋의 분산을 측정하고 최대가 되는 방향을 찾아서 차원을 축소하는 것을 확인할 수 있습니다. 반면, LDA는 Class의 분류(Speration)가 잘되는 축을 찾는 것을 의미합니다. 오른쪽 아래 그림에서 처럼 y축에 Projection을 시킨다면, 두 집단을 분류할 수 없게 됩니다. 때문에 x축 방향처럼 Projection 시킨 다면 두 집단의 Class를 잘 구분할 수 있게 됩니다.

<Referrence>

https://medium.com/@viveksalunkhe80/linear-discriminant-analysis-2b7bfc409f9b

https://sebastianraschka.com/Articles/2014_python_lda.html

https://laptrinhx.com/linear-discriminant-analysis-24934449/https://ars.els-cdn.com/content/image/1-s2.0-S1053811921007837-gr1_lrg.jpg

'빅데이터 > 통계노트' 카테고리의 다른 글

| 파생변수 요약변수 Derived Variable Summary Variable [빅공남! 통계 같이해요] (0) | 2022.03.01 |

|---|---|

| SVD Singular Value Decomposition 특이값분해 [빅공남! 통계 같이해요] (1) | 2022.02.24 |

| Scree Plot PCA Eigenvalue Explained Ratio [빅공남! 통계 같이해요 ] (0) | 2022.02.09 |

| PCA Principle Component Analysis 주성분분석 [빅공남! 통계 같이해요] (0) | 2022.02.05 |

| Feature Selection Feature Extraction 차원축소 PCA LDA t-SNE SVD [빅공남! 통계 같이해요] (0) | 2022.01.29 |

댓글